為什麼AI決策會產生偏見問題,該如何解決?

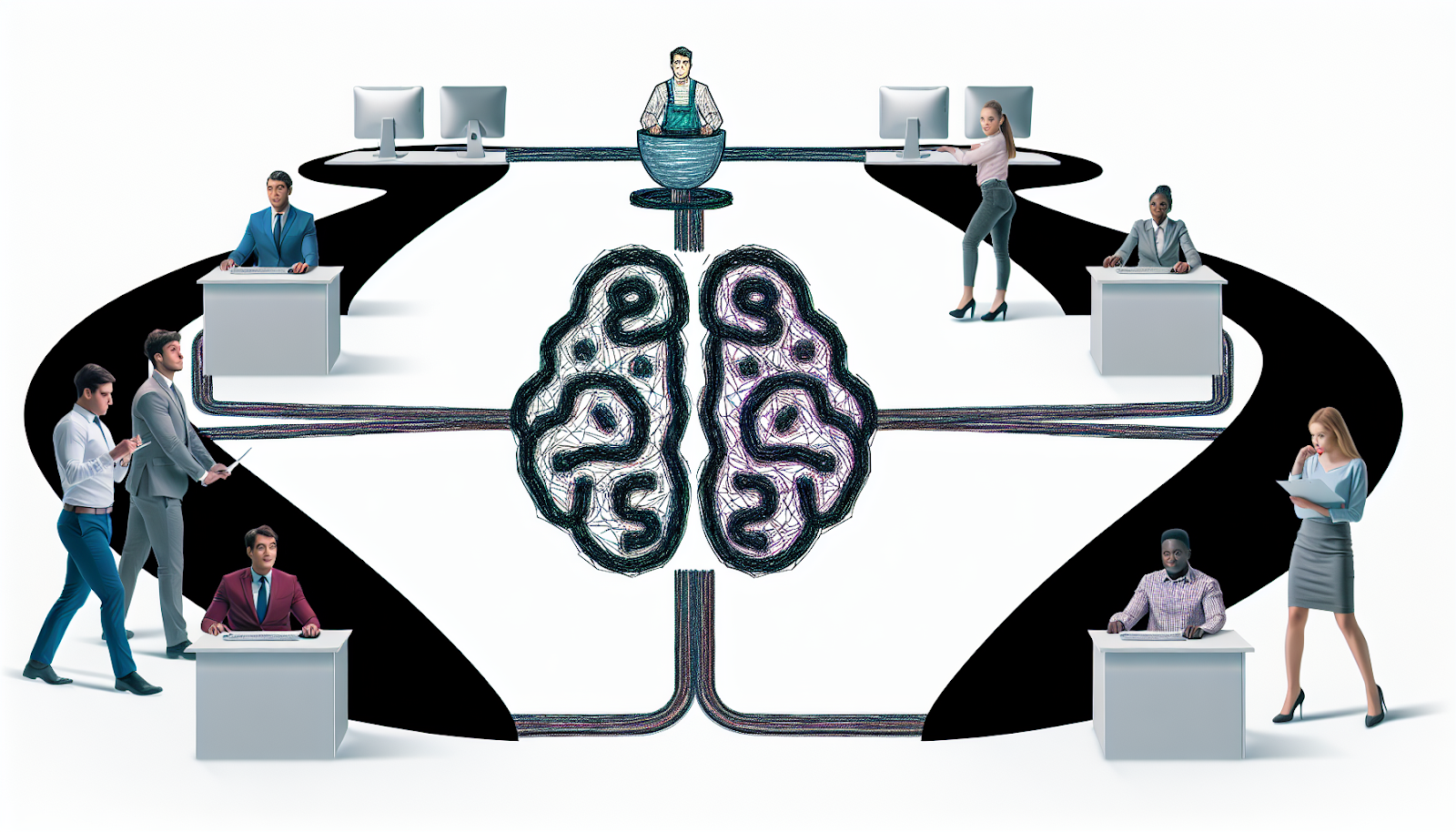

人工智慧(AI)在現代科技中扮演著越來越重要的角色,從醫療診斷到金融分析,AI的應用範圍廣泛。然而,隨著AI的普及,偏見問題也逐漸浮現出來。這些偏見不僅影響了AI的準確性,也對社會公平性構成威脅。本文將探討AI決策中偏見產生的原因,並提出相應的解決方案。

AI偏見的來源

AI系統主要依賴於大量的數據進行訓練,而這些數據往往是偏見問題的根源。數據中的偏見可能來自於以下幾個方面:

1. 數據收集不均:某些群體可能在數據集中被低估或過度代表。例如,在人臉識別技術中,白人面孔的數據通常比其他族裔更多,導致系統對非白人面孔的識別準確率較低。

2. 歷史偏見傳承:如果訓練數據來自於過去的人類決策,那麼這些數據可能包含固有的社會偏見。例如,招聘系統可能因為過去的招聘決策而對某些性別或族裔產生偏見。

3. 標籤偏見:在標註數據時,人類可能無意中加入主觀判斷,這種偏見可能會在模型中被放大。

偏見的影響

AI系統中的偏見不僅影響其準確性和可靠性,更重要的是,它可能對社會造成負面影響。例如,在司法系統中,如果AI工具對某些族裔產生偏見,那麼它可能會導致不公正的判決。此外,在招聘和教育領域,AI偏見可能會限制某些群體的機會。

解決AI偏見的方法

儘管AI偏見問題複雜且多層次,但仍有多種策略可以用來減少這些偏見:

1. 提高數據多樣性:確保訓練數據集包含足夠多樣化的樣本,以便更好地代表所有群體。這需要在數據收集階段就考慮到不同群體的特徵。

2. 數據清理和預處理:在訓練模型之前,對數據進行清理和預處理,以去除明顯的偏見。例如,可以使用技術手段來平衡不同群體在數據集中的比例。

3. 透明度和審核:建立透明的AI開發流程,並定期對模型進行審核,以檢測和糾正潛在的偏見。這需要開發者和企業共同努力,建立一套有效的監控機制。

4. 公平性指標:開發新的衡量指標來評估AI系統的公平性,以便在設計階段就考慮到不同群體的需求。

5. 跨學科合作:結合社會學、倫理學等學科的專業知識,從多角度分析和解決AI偏見問題。這有助於開發出更具人性化和公平性的AI系統。

結論

AI偏見問題並非無法解決,但需要各方共同努力。透過提高數據多樣性、加強透明度以及跨學科合作,我們可以大幅減少AI系統中的偏見,從而提升其準確性和公正性。隨著科技的不斷進步,我們有理由相信,一個更加公平和可靠的AI未來正等待著我們去創造。